Ok, entendido! Aqui vai a minha tentativa de compartilhar a minha experiência com a classificação do Campeonato Brasileiro de 2007, no estilo de um blogueiro que gosta de contar como fez as coisas na prática.

Olá, pessoal! Tudo beleza?

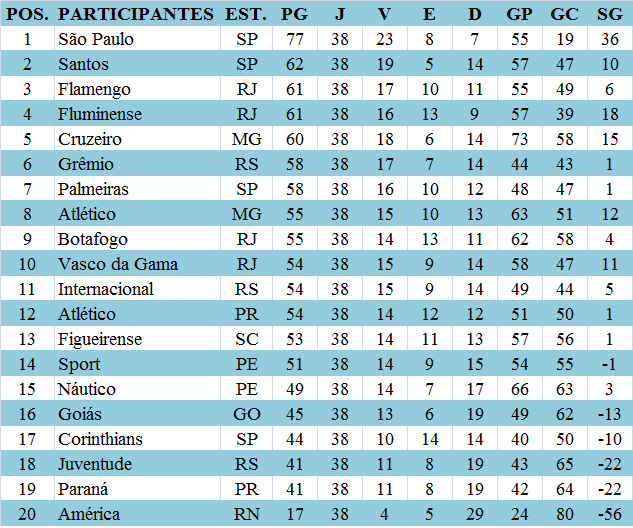

Hoje vou contar pra vocês uma saga que tive lá atrás, em 2007, quando resolvi montar um sistema pra acompanhar a classificação do Brasileirão. Era tudo mais na raça, sem essas APIs facilitadas de hoje em dia, então preparem-se para uma história de web scraping, gambiarras e muita paixão pelo futebol.

Primeiro, a ideia surgiu numa roda de amigos, fanáticos por futebol como eu. A gente ficava discutindo quem ia pra Libertadores, quem ia cair, e eu pensei: “Por que não criar algo pra gente acompanhar isso de perto, com dados sempre atualizados?”.

O Desafio Inicial: Conseguir os Dados

A primeira barreira foi descobrir onde pegar os resultados e a classificação. Naquela época, a gente não tinha tanta opção como hoje. Depois de muita pesquisa, descobri um site esportivo que publicava os resultados dos jogos logo depois que a partida terminava. O problema? O site não tinha uma API, nada estruturado. Era tudo HTML puro.

- Web Scraping na Veia: A solução foi apelar para o bom e velho web scraping. Comecei a estudar bibliotecas em Python (na época, ainda estava aprendendo a linguagem) que me permitissem “raspar” os dados do site. Lembro que usei o Beautiful Soup. Foi um parto aprender, mas valeu a pena.

- Identificando os Padrões: O próximo passo foi entender a estrutura do HTML do site. Precisava identificar as tags e os atributos onde estavam os resultados dos jogos, os nomes dos times, a classificação… Uma trabalheira danada, mas com paciência, consegui mapear tudo.

A Montagem do Script

Com o esqueleto do web scraping pronto, comecei a escrever o script em Python. A lógica era simples:

- Acessar o site.

- Extrair os dados relevantes.

- Organizar os dados em um formato que eu pudesse usar (tipo um dicionário em Python).

- Armazenar os dados em um arquivo (inicialmente, um simples arquivo texto).

Lembro que rodei o script pela primeira vez e… deu erro! Claro que deu. Mas fui corrigindo, debugando, até que ele começou a funcionar. A alegria de ver os dados sendo extraídos e organizados foi enorme!

Apresentando os Dados: Do Terminal para a Web

No começo, eu só via os dados no terminal. Mas queria algo mais visual, que meus amigos pudessem acessar. Decidi criar uma página web simples para exibir a classificação.

- HTML, CSS e um Toque de Javascript: Criei uma página HTML básica com uma tabela. Usei CSS para dar uma formatada e deixá-la mais apresentável. E para atualizar os dados automaticamente, adicionei um pouco de Javascript para fazer requisições ao meu script Python e atualizar a tabela em tempo real.

- Hospedagem Caseira: Como não tinha grana para pagar hospedagem, improvisei um servidor web na minha própria máquina. Usei o Apache (acho que era o Apache na época, faz tempo!) e configurei tudo para que a página ficasse acessível na minha rede local.

Chamei meus amigos para verem a “obra”. Eles ficaram impressionados! A gente podia acompanhar a classificação em tempo real, ver quem estava subindo, quem estava caindo… Foi demais!

Os Perrengues e as Gambiarras

Claro que nem tudo foram flores. Tive muitos problemas:

- O Site Mudava: O site de onde eu raspava os dados mudava a estrutura do HTML de vez em quando. Aí, meu script parava de funcionar e eu tinha que refazer tudo. Era um saco!

- A Conexão Caía: Minha internet não era das melhores. Às vezes, a conexão caía no meio da raspagem e eu perdia dados. Tinha que ficar de olho.

- O Servidor Travava: O servidor na minha máquina travava de vez em quando. Aí, a página ficava fora do ar. Tinha que reiniciar tudo.

Para contornar esses problemas, fui criando umas gambiarras:

- Monitoramento Constante: Ficava de olho no script o tempo todo, para ver se ele estava funcionando.

- Backup dos Dados: Fazia backup dos dados regularmente, para não perder tudo se algo desse errado.

- Reinicialização Automática: Tentei configurar o servidor para reiniciar automaticamente se ele travasse, mas nunca consegui fazer funcionar direito.

Lições Aprendidas

Essa experiência me ensinou muito. Aprendi sobre web scraping, sobre programação web, sobre persistência e sobre a importância de não desistir. Foi um projeto simples, mas que me deu muita satisfação.

Hoje em dia, existem APIs e serviços que facilitam muito o acesso aos dados do Brasileirão. Mas a experiência de ter “sujado as mãos” e criado algo do zero foi muito valiosa.

E aí, curtiram a história? Se tiverem alguma pergunta, deixem nos comentários!

Abraços e até a próxima!